Apache Spark 3.0.0 自2018年10月02日开发到目前已经经历了近21个月!这个版本的发布经历了两个预览版以及三次投票:

2019年11月06日第一次预览版,参见Preview release of Spark 3.0;

2019年12月23日第二次预览版,参见Preview release of Spark 3.0;

2020年03月21日 [VOTE] Apache Spark 3.0.0 RC1;

2020年05月18日 [VOTE] Apache Spark 3.0 RC2;

2020年06月06日 [vote] Apache Spark 3.0 RC3。

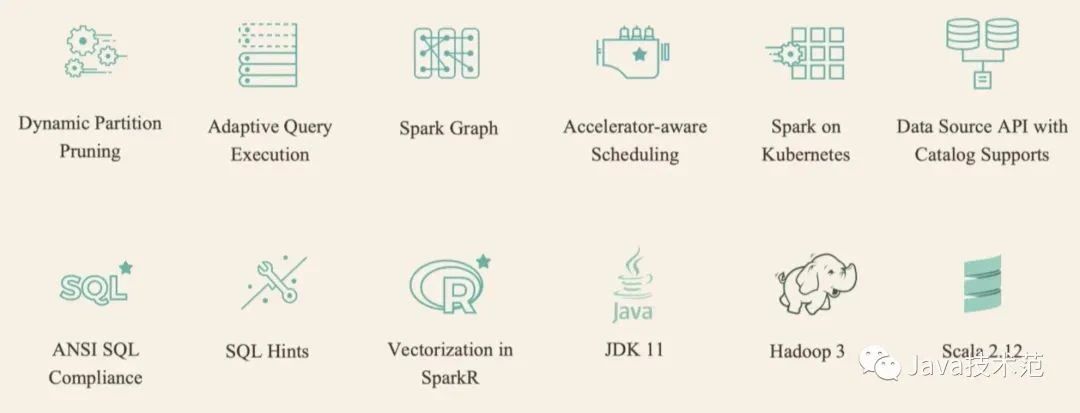

Apache Spark 3.0 增加了很多令人兴奋的新特性,包括:

动态分区修剪(Dynamic Partition Pruning);

自适应查询执行(Adaptive Query Execution);

加速器感知调度(Accelerator-aware Scheduling);

支持 Catalog 的数据源API(Data Source API with Catalog Supports);

SparkR 中的向量化(Vectorization in SparkR);

支持 Hadoop 3/JDK 11/Scala 2.12 等等。

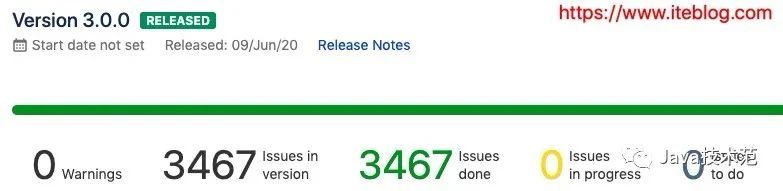

这个版本一共解决了 3400 多个 ISSUES。

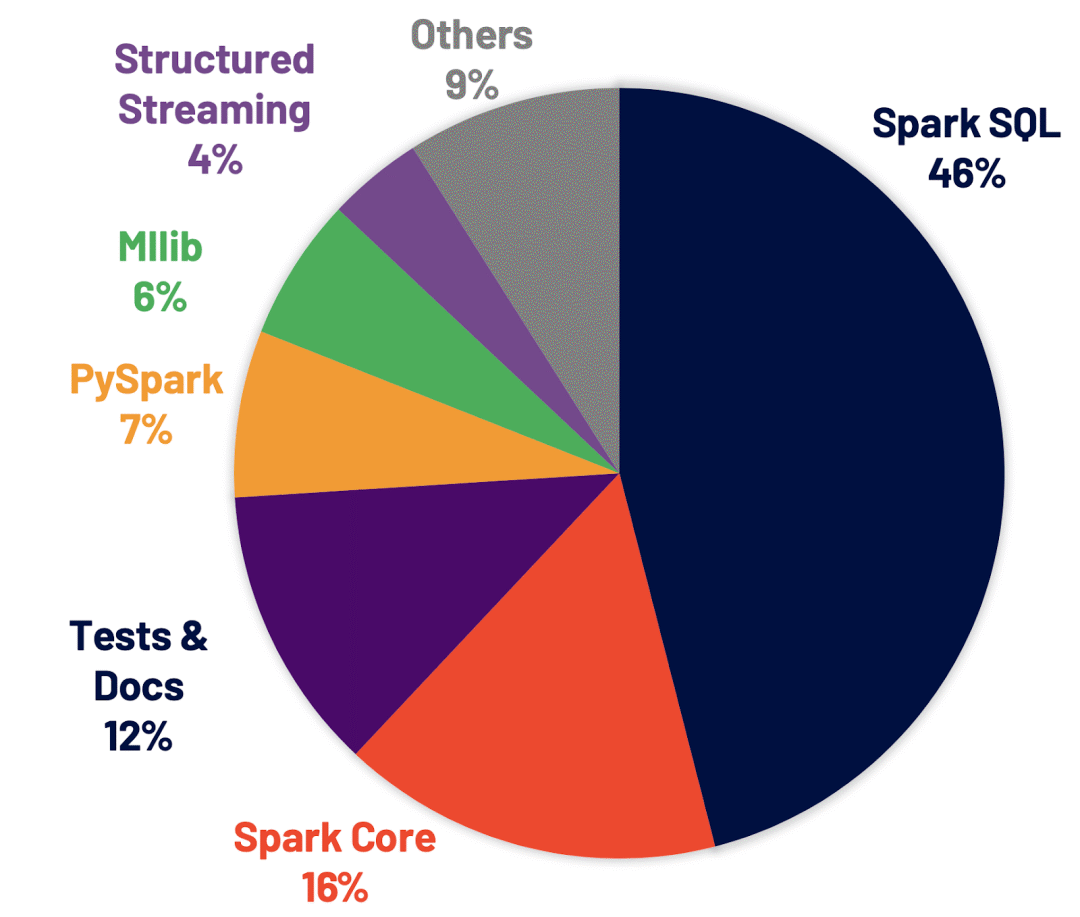

这 3400 多个 issues 在 Spark 各个组件的分布情况如下:

Apache Spark 3.0.0 中主要特性如下:

下面我们来快速看看 Spark 3.0 比较重要的新特性吧。

一、动态分区修剪(Dynamic Partition Pruning)

所谓的动态分区裁剪就是基于运行时(run time)推断出来的信息来进一步进行分区裁剪。举个例子,我们有如下的查询:

SELECT * FROM dim_iteblog

JOIN fact_iteblog

ON (dim_iteblog.partcol = fact_iteblog.partcol)

WHERE dim_iteblog.othercol > 10

假设 dim_iteblog 表的 dim_iteblog.othercol > 10 过滤出来的数据比较少,但是由于之前版本的 Spark 无法进行动态计算代价,所以可能会导致 fact_iteblog 表扫描出大量无效的数据。

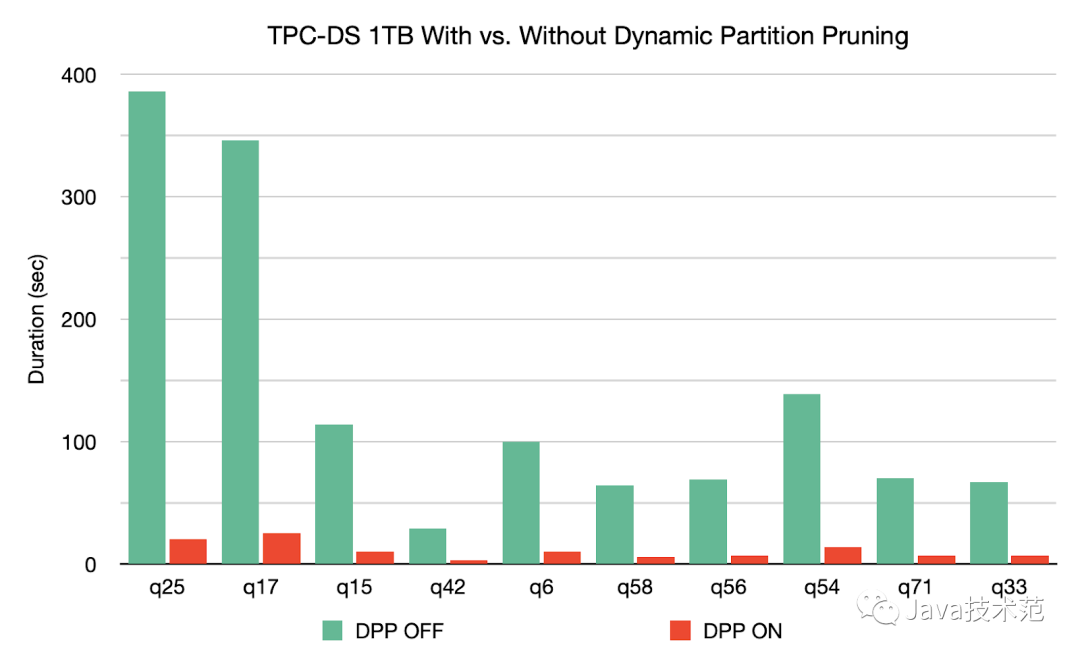

有了动态分区裁减,可以在运行的时候过滤掉 fact_iteblog 表无用的数据。经过这个优化,查询扫描的数据大大减少,性能提升了 33 倍。

在 TPC-DS 基准测试中,102个查询中的60个得到2到18倍的加速。

这个特性对应的 ISSUE 可以参见 SPARK-11150 和 SPARK-28888。具体请参见《Apache Spark 3.0 动态分区裁剪(Dynamic Partition Pruning)介绍》和《Apache Spark 3.0 动态分区裁剪(Dynamic Partition Pruning)使用》。

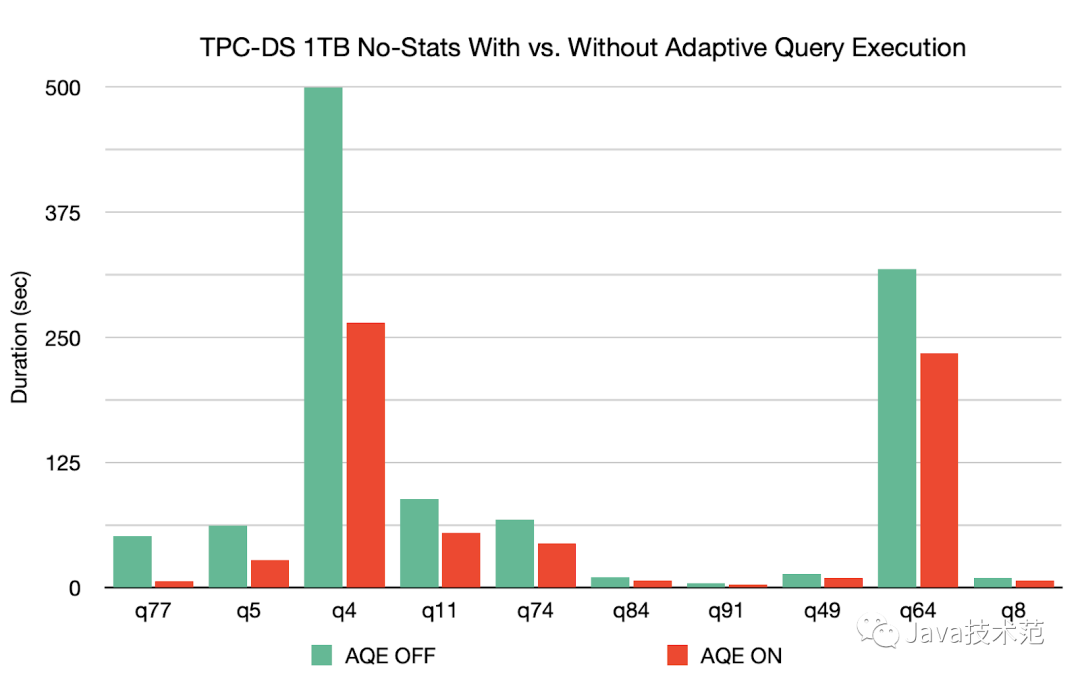

二、自适应查询执行(Adaptive Query Execution)

自适应查询执行(又称 Adaptive Query Optimisation 或者 Adaptive Optimisation)是对查询执行计划的优化,允许 Spark Planner 在运行时执行可选的执行计划,这些计划将基于运行时统计数据进行优化。

早在2015年,Spark 社区就提出了自适应执行的基本想法,在 Spark 的 DAGScheduler 中增加了提交单个 map stage 的接口,并且在实现运行时调整 shuffle partition 数量上做了尝试。

但目前该实现有一定的局限性,在某些场景下会引入更多的 shuffle,即更多的 stage,对于三表在同一个 stage 中做 join 等情况也无法很好的处理;而且使用当前框架很难灵活地在自适应执行中实现其他功能,例如更改执行计划或在运行时处理倾斜的 join。

所以该功能一直处于实验阶段,配置参数也没有在官方文档中提及。这个想法主要来自英特尔以及百度的大牛,具体参见 SPARK-9850,对应的文章可以参见《Apache Spark SQL自适应执行实践》。

而 Apache Spark 3.0 的 Adaptive Query Execution(AQE) 是基于 SPARK-9850 的思想而实现的,具体参见 SPARK-23128。

SPARK-23128 的目标是实现一个灵活的框架以在 Spark SQL 中执行自适应执行,并支持在运行时更改 reducer 的数量。新的实现解决了前面讨论的所有限制,其他功能(如更改 join 策略和处理倾斜 join)将作为单独的功能实现,并作为插件在后面版本提供。

AQE 框架目前提供了三个功能:

动态合并 shuffle partitions;

动态调整 join 策略;

动态优化倾斜的 join(skew joins)。

基于没有统计数据的 1TB TPC-DS 基准,Spark 3.0 可以使 q77 的速度提高8倍,使 q5 的速度提高2倍,而对另外26个查询的速度提高1.1倍以上。可以通过设置 SQL 配置 spark.sql.adaptive=true 来启用 AQE,这个参数默认值为 false。

三、加速器感知调度(Accelerator-aware Scheduling)

如今大数据和机器学习已经有了很大的结合,在机器学习里面,因为计算迭代的时间可能会很长,开发人员一般会选择使用 GPU、FPGA 或 TPU 来加速计算。在 Apache Hadoop 3.1 版本里面已经开始内置原生支持 GPU 和 FPGA 了。

作为通用计算引擎的 Spark 肯定也不甘落后,来自 Databricks、NVIDIA、Google 以及阿里巴巴的工程师们正在为 Apache Spark 添加原生的 GPU 调度支持,该方案填补了 Spark 在 GPU 资源的任务调度方面的空白,有机地融合了大数据处理和 AI 应用,扩展了 Spark 在深度学习、信号处理和各大数据应用的应用场景。

这项工作的 issue 可以在 SPARK-24615 里面查看,相关的 SPIP(Spark Project Improvement Proposals) 文档可以参见 SPIP: Accelerator-aware scheduling。《Apache Hadoop 3.1.0 正式发布,原生支持GPU和FPGA》。

目前 Apache Spark 支持的资源管理器 YARN 和 Kubernetes 已经支持了 GPU。为了让 Spark 也支持 GPUs,在技术层面上需要做出两个主要改变:

在 cluster manager 层面上,需要升级 cluster managers 来支持 GPU。并且给用户提供相关 API,使得用户可以控制 GPU 资源的使用和分配;

在 Spark 内部,需要在 scheduler 层面做出修改,使得 scheduler 可以在用户 task 请求中识别 GPU 的需求,然后根据 executor 上的 GPU 供给来完成分配。

因为让 Apache Spark 支持 GPU 是一个比较大的特性,所以项目分为了几个阶段。在 Apache Spark 3.0 版本,将支持在 standalone、 YARN 以及 Kubernetes 资源管理器下支持 GPU,并且对现有正常的作业基本没影响。对于 TPU 的支持、Mesos 资源管理器中 GPU 的支持、以及 Windows 平台的 GPU 支持将不是这个版本的目标。

而且对于一张 GPU 卡内的细粒度调度也不会在这个版本支持;Apache Spark 3.0 版本将把一张 GPU 卡和其内存作为不可分割的单元。《Apache Spark 3.0 将内置支持 GPU 调度》

四、Apache Spark DataSource V2

Data Source API 定义如何从存储系统进行读写的相关 API 接口,比如 Hadoop 的 InputFormat/OutputFormat,Hive 的 Serde 等。这些 API 非常适合用户在 Spark 中使用 RDD 编程的时候使用。

使用这些 API 进行编程虽然能够解决我们的问题,但是对用户来说使用成本还是挺高的,而且 Spark 也不能对其进行优化。

为了解决这些问题,Spark 1.3 版本开始引入了 Data Source API V1,通过这个 API 我们可以很方便的读取各种来源的数据,而且 Spark 使用 SQL 组件的一些优化引擎对数据源的读取进行优化,比如列裁剪、过滤下推等等。

Data Source API V1 为我们抽象了一系列的接口,使用这些接口可以实现大部分的场景。但是随着使用的用户增多,逐渐显现出一些问题:

部分接口依赖 SQLContext 和 DataFrame;

扩展能力有限,难以下推其他算子;

缺乏对列式存储读取的支持;

缺乏分区和排序信息;

写操作不支持事务;

不支持流处理。

为了解决 Data Source V1 的一些问题,从 Apache Spark 2.3.0 版本开始,社区引入了 Data Source API V2,在保留原有的功能之外,还解决了 Data Source API V1 存在的一些问题,比如不再依赖上层 API,扩展能力增强。Data Source API V2 对应的 ISSUE 可以参见 SPARK-15689。

虽然这个功能在 Apache Spark 2.x 版本就出现了,但是不是很稳定,所以社区对 Spark DataSource API V2 的稳定性工作以及新功能分别开了两个 ISSUE:SPARK-25186 以及 SPARK-22386。

Spark DataSource API V2 最终稳定版以及新功能将会随着年底和 Apache Spark 3.0.0 版本一起发布,其也算是 Apache Spark 3.0.0 版本的一大新功能。《一文理解 Apache Spark DataSource V2 诞生背景及入门实战》。

五、丰富的 API 和功能

为了满足新的用例并简化 Spark 应用程序的开发,Apache Spark 3.0 版本提供了新的功能并增强了现有的功能。

Pandas UDF 最初是在 Spark 2.3 中引入的,用于扩展 PySpark 中 UDF 并将 pandas API 集成到 PySpark 应用程序中。但是,当添加更多 UDF 类型时,现有接口很难理解。为了解决这个问题,Spark 3.0 引入了带有 Python 类型提示的新 pandas UDF 接口。

此版本增加了两种新的 pandas UDF 类型:iterator of series to iterator of series 和 iterator of multiple series to iterator of series,以及三个新的 pandas 函数 API:grouped map、map 和 co-grouped map。

Apache Spark 3.0 新的 Pandas UDF 及 Python Type Hints:https://www.iteblog.com/archives/9814.html

尽管社区不断提高编译器的智能性,但不能保证编译器始终可以针对每种情况做出最佳决策。Join 算法的选择基于统计和启发式算法,当编译器无法做出最佳选择时,用户仍然可以使用 join hints 来影响优化器选择更好的计划。

Apache Spark 3.0 通过添加新的 hints 扩展了现有的 join hints :SHUFFLE_MERGE、SHUFFLE_HASH 和 SHUFFLE_REPLICATE_NL

Scala API 中增了32个新的内置函数和高阶函数。在这些内置函数中,添加了一组针对 MAP 的特定内置函数[transform_key,transform_value,map_entries,map_filter,map_zip_with],以简化对 MAP 数据类型的处理。

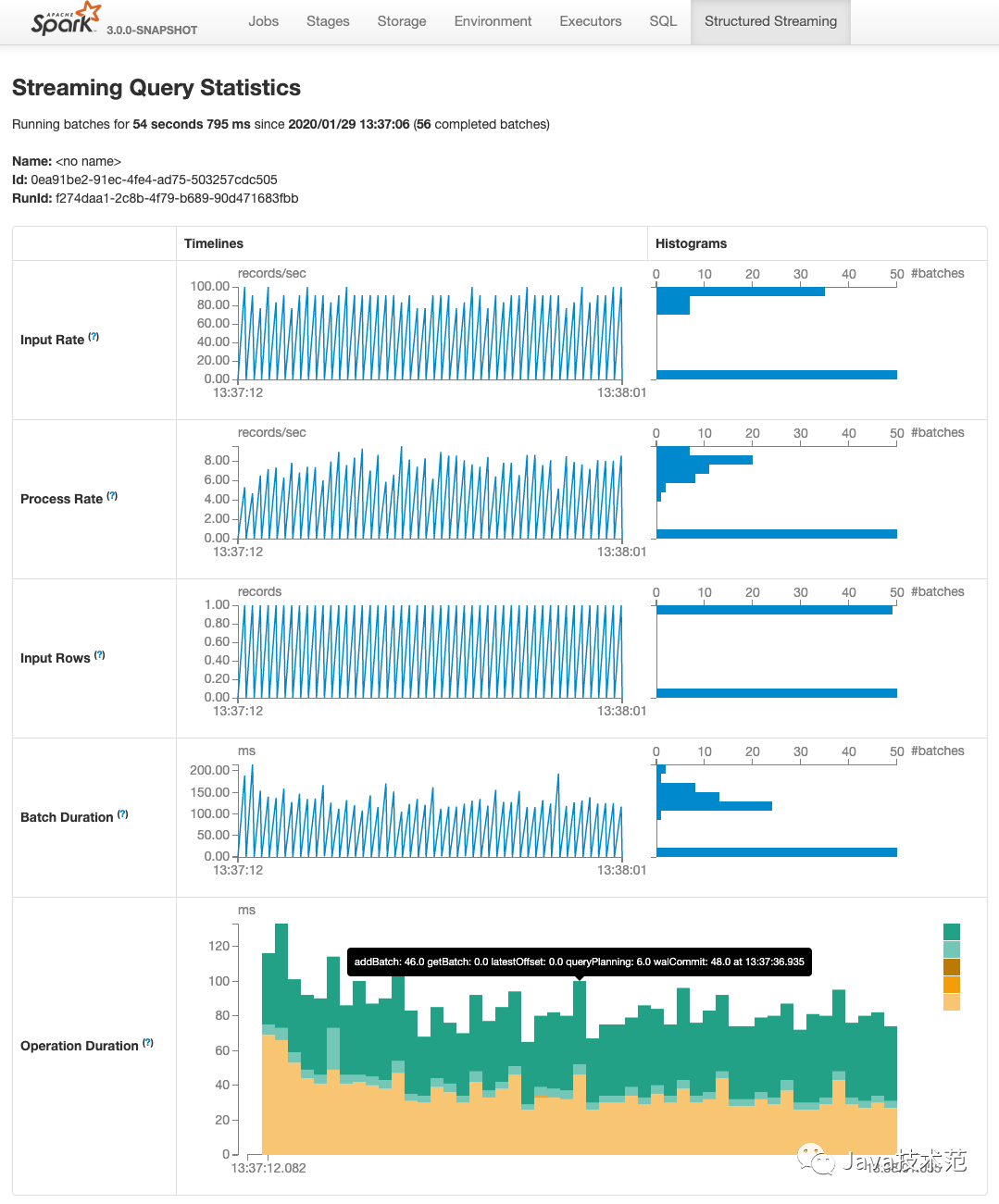

六、增强的监控功能

Apache Spark 在监控方面也包含许多增强功能,这些功能使监控更加全面和稳定。这些增强的监控功能不会对性能产生重大影响。主要可以分为以下三个地方:

Structured streaming 最初是在 Spark 2.0 中引入的。Spark 3.0 为监控这些流作业重新设计了 UI。这个新的 UI 提供了两组统计信息:

已完成的流查询作业的聚合信息。

流查询的详细统计信息,包括 Input Rate, Process Rate, Input Rows, Batch Duration, Operation Duration 等。

读取计划(Reading plans)对理解和调优查询非常重要。现有的解决方案看起来很混乱,每个算子的字符串表示可能非常宽,甚至可能被截断。Spark 3.0 版本使用一种新的格式化(FORMATTED)模式对其进行了增强,并且还提供了将计划转储到文件的功能。

连续监视数据质量的变化是管理数据管道非常需要的特性。Spark 3.0 版本为批处理和流处理应用程序引入了这种功能。可观察指标被命名为可以在查询上定义的任意聚合函数(dataframe)。一旦 dataframe 的执行到达一个完成点(例如,完成批查询),就会发出一个命名事件,其中包含自上一个完成点以来处理的数据的指标。

七、更好的 ANSI SQL 兼容

PostgreSQL 是最先进的开源数据库之一,其支持 SQL:2011 的大部分主要特性,完全符合 SQL:2011 要求的 179 个功能中,PostgreSQL 至少符合 160 个。

Spark 社区目前专门开了一个 ISSUE SPARK-27764 来解决 Spark SQL 和 PostgreSQL 之间的差异,包括功能特性补齐、Bug 修改等。功能补齐包括了支持 ANSI SQL 的一些函数、区分 SQL 保留关键字以及内置函数等。

这个 ISSUE 下面对应了 231 个子 ISSUE,如果这部分的 ISSUE 都解决了,那么 Spark SQL 和 PostgreSQL 或者 ANSI SQL:2011 之间的差异更小了。

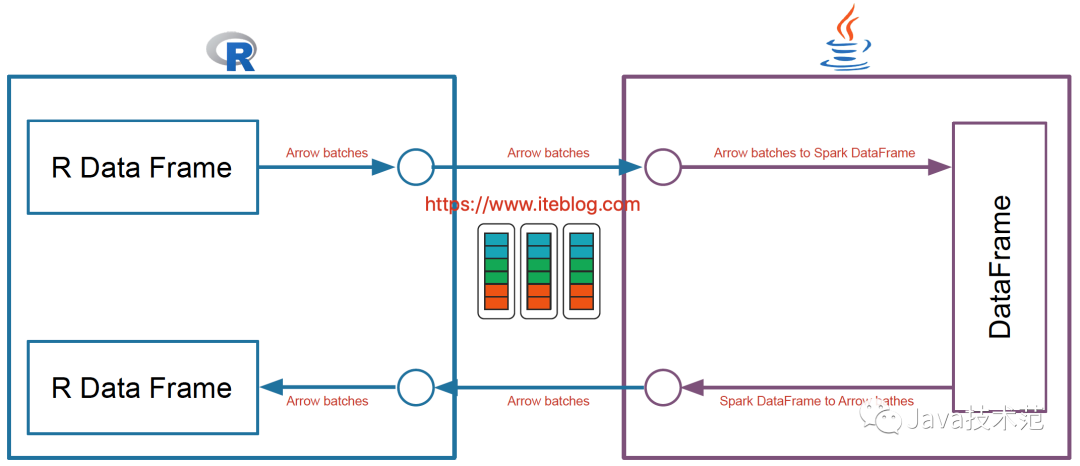

八、SparkR 向量化读写

Spark 是从 1.4 版本开始支持 R 语言的,但是那时候 Spark 和 R 进行交互的架构图如下:

每当我们使用 R 语言和 Spark 集群进行交互,需要经过 JVM ,这也就无法避免数据的序列化和反序列化操作,这在数据量很大的情况下性能是十分低下的!

而且 Apache Spark 已经在许多操作中进行了向量化优化(vectorization optimization),例如,内部列式格式(columnar format)、Parquet/ORC 向量化读取、Pandas UDFs 等。

向量化可以大大提高性能。SparkR 向量化允许用户按原样使用现有代码,但是当他们执行 R 本地函数或将 Spark DataFrame 与 R DataFrame 互相转换时,可以将性能提高大约数千倍。这项工作可以看下 SPARK-26759。新的架构如下:

可以看出,SparkR 向量化是利用 Apache Arrow,其使得系统之间数据的交互变得很高效,而且避免了数据的序列化和反序列化的消耗,所以采用了这个之后,SparkR 和 Spark 交互的性能得到极大提升。

九、Kafka Streaming: includeHeaders

Apache Kafka 0.11.0.0 版本支持在消息中配置一些 headers 信息,具体参见 KIP-82 - Add Record Headers,对应的 ISSUE 参见 KAFKA-4208。这些 Headers 在一些场景下很有用,Spark 3.0.0 为了满足用户的场景所以当然需要支持这个功能了,具体参见 SPARK-23539。具体使用如下:

val df = spark

.readStream

.format("kafka")

.option("kafka.bootstrap.servers", "host1:port1,host2:port2")

.option("subscribe", "topic1")

.option("includeHeaders", "true")

.load()

df.selectExpr("CAST(key AS STRING)", "CAST(value AS STRING)", "headers") .as[(String, String, Map)]

十、其他

Spark on K8S:Spark 对 Kubernetes 的支持是从2.3版本开始的,Spark 2.4 得到提升,Spark 3.0 将会加入 Kerberos 以及资源动态分配的支持;

Remote Shuffle Service:当前的 Shuffle 有很多问题,比如弹性差、对 NodeManager 有很大影响,不适应云环境。为了解决上面问题,将会引入 Remote Shuffle Service,具体参见 SPARK-25299;

支持 JDK 11:参见 SPARK-24417,之所以直接选择 JDK 11 是因为 JDK 8 即将达到 EOL(end of life),而 JDK9 和 JDK10 已经是 EOL,所以社区就跳过 JDK9 和 JDK10 而直接支持 JDK11。不过 Spark 3.0 预览版默认还是使用 JDK 1.8;

移除对 Scala 2.11 的支持,默认支持 Scala 2.12,具体参见 SPARK-26132;

支持 Hadoop 3.2,具体参见 SPARK-23710,Hadoop 3.0 已经发布了2年了,《Apache Hadoop 3.0.0-beta1 正式发布,2017-11-01发布GA版即可在线上使用》所以支持 Hadoop 3.0 也是自然的,不过 Spark 3.0 预览版默认还是使用 Hadoop 2.7.4;

移除 Python 2.x 的支持:早在 2019年6月社区就有相关的讨论关于在 Spark 3.0 移除对 Python 2 的支持,目前 Spark 3.0.0 默认支持 Python 3.x ,参见 SPARK-27884;

Spark Graph 支持 Cypher:Cypher 是流行的图查询语言,现在我们可以直接在 Spark 3.0 使用 Cypher。

Spark event logs 支持 Roll 了,参见 《Spark 3.0 终于支持 event logs 滚动了》。

参考资料

Preview release of Spark 3.0: https://spark.apache.org/news/spark-3.0.0-preview.html

Preview release of Spark 3.0: https://spark.apache.org/news/spark-3.0.0-preview2.html

[VOTE] Apache Spark 3.0.0 RC1: https://www.mail-archive.com/dev@spark.apache.org/msg25781.html

[VOTE] Apache Spark 3.0 RC2: https://www.mail-archive.com/dev@spark.apache.org/msg26040.htm

[vote] Apache Spark 3.0 RC3: https://www.mail-archive.com/dev@spark.apache.org/msg26119.html

https://spark.apache.org/releases/spark-release-3-0-0.html

SPIP: Accelerator-aware scheduling: https://issues.apache.org/jira/secure/attachment/12960252/SPIP_%20Accelerator-aware%20scheduling.pdf

近年来大数据技术发展迅猛,不断推陈出新抵抗新时代的海量数据处理挑战。但随着技术的更迭,每次演进都需要耗费大量的人力物力,传统的数据管理模式已摇摇欲坠,此时DataOps应运而生。9月11日来Gdevops全球敏捷运维峰会北京站一起看看联通大数据背后的DataOps体系建设:

《数据智能时代:构建能力开放的运营商大数据DataOps体系》中国联通大数据基础平台负责人/资深架构师 尹正军

此议题将讲述联通大数据背后的DataOps平台整体架构演进,包括数据采集交换加工过程、数据治理体系、数据安全管控、能力开放平台运营和大规模集群治理等核心实践内容。

如果字段的最大可能长度超过255字节,那么长度值可能…

只能说作者太用心了,优秀

感谢详解

一般干个7-8年(即30岁左右),能做到年入40w-50w;有…

230721